* ANN의 등장 배경

1. 생물학적 신경망에서 아이디어를 얻었다. (퍼셉트론 등장)

<퍼셉트론(Perceptron)> : 생물학적 뉴런을 공학적으로 변형한 그림

- 입력층(input)과 출력층(output)을 가지고 있다.

- 입력값에 가중치를 곱한 후 바이어스(b)를 더한 후 활성함수의 입력값으로 대입하여 출력값은 0또는 1이 된다.

- 선형이중분류기(Linear Binary Classifier)이다.

(퍼셉트론의 활성함수)

- 계단함수이다.(0보다 크면 1, 작으면 0을 출력)

**퍼셉트론의 한계

- 단순한 선형분류기에 불과하며 XOR 문제는 해결 할 수 없다.(선형분리만 가능하기 때문)

2. 퍼셉트론의 아이디어를 연구하여 다중퍼셉트론 개념 등장

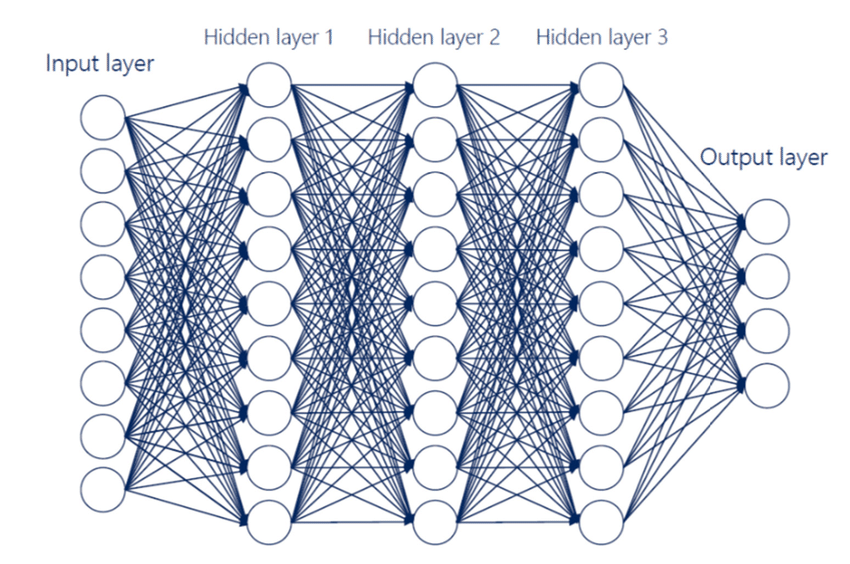

<다중 퍼셉트론(Multi-Layer Percetron, MLP)> = 인공신경망(ANN)

- 퍼셉트론을 여러층 쌓아 올린 형태

- 선형 분리가 불가능한 문제도 해결 가능하게 됨

- 입력층(input), 출력층(output), 은닉층(Hidden Layer)으로 구성되어 있음

- 은닉층은 입,출력 과정에서 보이지 않지만 숨겨진 특성을 학습하는 역할을 한다.

- 다중 퍼셉트론의 노드는 퍼셉트론으로 이루어져 있고, output의 값을 다시 input하여 연산이 진행됨

- 분류기가 비선형적인 특징을 학습할 수 있도록 만드는 것이 목적

(다중퍼셉트론의 활성함수)

- 시그모이드(Sigmoid), 쌍곡 탄젠트(Tangent Hyperbolic(Tahn)) 혹은 ReLU를 사용

- 기존에는 시그모이드 함수를 주로 썼었는데 현재는 ReLU 함수를 주로 사용한다.

- Sigmoid & Tanh 함수같은 경우에는, 어느 범위에서 벗어나면 미분값이 0이 되기 때문에 학습이 어렵게 되지만,

ReLU 함수는 0보다 값이 커지게 되면 선형적으로 값이 커지므로 미분값을 구할 수 있다.

3. 다중퍼셉트론의 은닉층을 깊게 여러번 쌓아 올린 형태 등장(깊은 인공 신경망, Deep Neural Networks, DNN)

- 이 구조가 현재 지칭하는 딥러닝이라고 부르는 기법이다.

'Machine Learning' 카테고리의 다른 글

| [머신러닝] 오토인코더(Auto Encoder) (0) | 2021.11.25 |

|---|---|

| [머신러닝] 최적화 알고리즘 - 경사하강법(Gradient Descent) (0) | 2021.10.20 |

| [머신러닝] Integer Encoding & One-hot Encoding (0) | 2021.10.02 |

| [머신러닝] Random Forest(랜덤 포레스트) (0) | 2021.10.02 |

| [머신 러닝] Regression 알고리즘 (0) | 2021.09.02 |